Seguindo a série de posts sobre recursos do SCVMM 2012 integrados com VMWare ESX e Xen Server agora abordaremos outro recurso que é o gerenciamento de storages. Post anteriores: Integração com live migration http://bit.ly/pf0v9M e Dynamic e Power Optimization http://bit.ly/pJ6KLf.

Com o VMM 2012 você poderá classificar storages pela performance, definir o storage a ser utilizado e criar as LUNs sem a necessidade de conhecer o software de cada fabricante. Ou seja, você poderá utilizar o conceito de virtualização de storage com as interfaces do VMM 2012.

API SMI-S

Uma nova funcionalidade que está sendo discutida com os fabricantes de storages é a criação de um protocolo de comunicação muito similar ao SNMP mas que permita detalhes das especificações de um storage, chamado de Storage Management Initiative Specification (SMI-S).

Este protocolo é um API baseada nos modelos CIM/WBEM, que muitos já conhecem por ser também a especificação básica do WMI presente nos sistemas operacionais Windows. Utilizar este procolo não é tão simples, e é necessário ter um CIMOM que nada mais é que um proxy para “traduzir” as APIs nativas do storage para o protocolo SMI-S.

Porem, os fabricantes de storages já tem estes padrões bem estabelecidos e com upgrades de firmware podem incluir o CIMOM, um deles é o OpenPegasus, no storage já existente.

SMI-S no VMM 2012

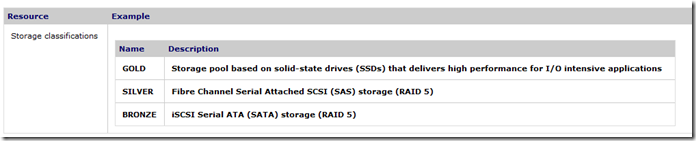

Agora entra em cena o VMM 2012 que possui a interface de comunicação SMI-S para se comunicar com os storages e obter informações, e com base nestas pode classificar os storages conforme a sua performance, como a tabela abaixo retirada do TechNet (referencia ao final do documento):

Automação de Storage no VMM 2012

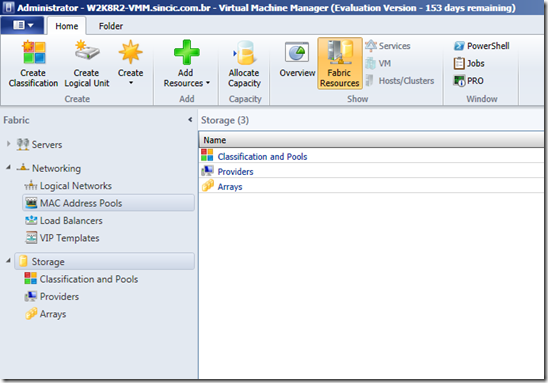

Agora podemos colocar em prática esta funcionalidade por criar arrays de storage e vincular aos hosts.

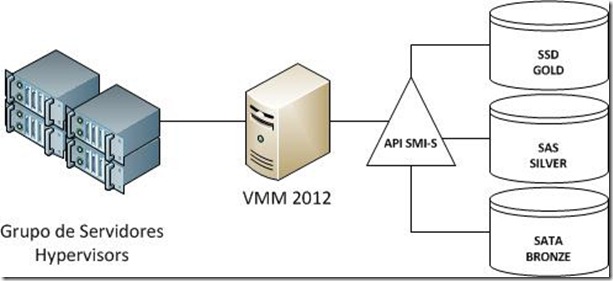

Imagine que em sua empresa haja storages com disco SAS e SATA, onde a classificação automática é SILVER e BRONZE respectivamente e tanto o grupo de servidores quanto uma VM pode ter especificado não a LUN, mas sim a classificação.

Essa automação inclui a criação das LUNs, ou seja, não será mais necessário ter conhecimento do software do fabricante para criar as LUNs individualmente já que a API SMI-S implementa os comandos necessário para gerenciar.

Figura 1 – Tela principal do gerenciador de storages

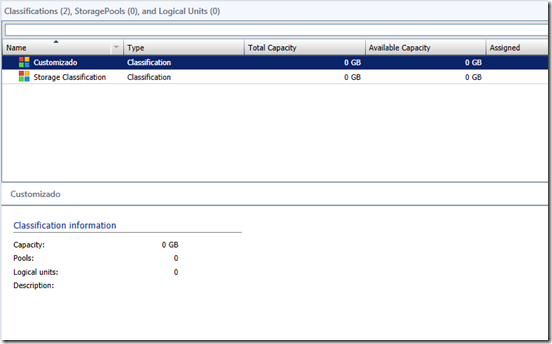

Figura 2 – Pool default e criação de um novo pool

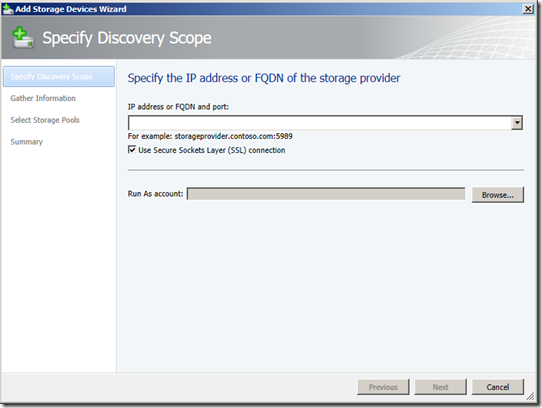

Figura 3 – Inclusão de um storage ao pool

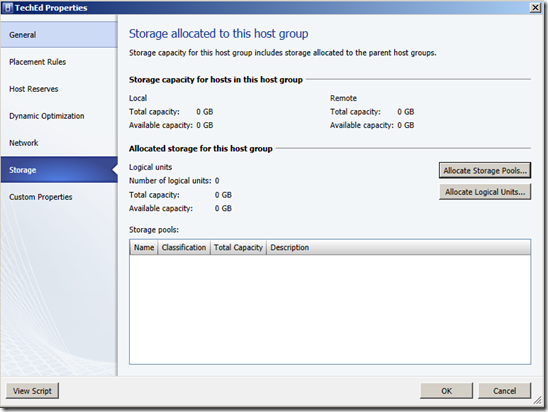

Figura 4 – Vinculando um storage pool a um grupo de hosts hypervisors

Com este recurso o gerenciamento de um datacenter será mais fácil, e quando temos diversos storages independentemente do fabricante poderemos utilizá-lo de forma simples com as APIs SMI-S.

Referencia TechNet http://technet.microsoft.com/en-us/library/gg610600.aspx e http://blogs.technet.com/b/server-cloud/archive/2011/10/14/windows-server-8-standards-based-storage-management.aspx